Justo antes de las fiestas navideñas asistimos a la octava edición de la conferencia Big Things, antes llamada Big Data Spain, donde pudimos conocer de primera mano las últimas tendencias e innovaciones en el ámbito de las tecnologías Big Data, Inteligencia Artificial y Transformación Digital. Con alrededor de 2000 asistentes, un 21% más que en la pasada edición, este año el evento acogió a 120 speakers en 92 presentaciones dispuestas a lo largo de cinco tracks en paralelo.

La nueva denominación viene motivada, en palabras de Óscar Méndez, presidente de la conferencia, porque “Big Data Spain era mucho más que Big Data. Por eso, creíamos conveniente un cambio de nombre que recogiera la variedad de tecnologías disruptivas de las que vienen a hablar en cada evento algunos de los mayores representantes de las mismas en el mundo”.

Según Carmen Vidal, CEO de Paradigma Digital, “la variedad de temáticas abordadas por los expertos asistentes en los últimos años y la demanda creciente de los asistentes por poder acceder en España al conocimiento más avanzado, tanto desde el punto de vista tecnológico como de negocio, nos hizo evolucionar el concepto hacia ‘las grandes cosas’ sobre las que se conversa en los mayores foros mundiales de innovación”.

Nos quedamos con un par de ideas transmitidas durante las keynotes de apertura:

- ‘La tecnología está cambiando el mundo’ (“Technology is changing the world”, Óscar Méndez, CEO y cofundador de Stratio), lo cual significa que las compañías no tienen tiempo que perder en términos de transformación digital: el momento es ahora; y

- ‘El mundo representado por tus datos es el único en el que puedes esperar tener éxito’ (“The world represented by your data is the only world you can expect to succeed in”, Cassie Kozyrkov, Chief Decision Scientist en Google Cloud), que es un mensaje claro para los encargados de gestionar y de analizar datos dentro de una organización.

Tendencias a tener (muy) en cuenta este 2020

Al igual que en el año pasado, en este post os traemos un breve resumen con lo más destacable que hemos podido ver en la edición 2019 de Big Things.

Big Data & IA en producción

Como eje central en numerosas charlas, constatamos que muchas compañías -no todas relacionadas con el ámbito TIC- se encuentran inmersas en procesos de digitalización donde resulta esencial aplicar los cambios de manera ordenada y siendo conscientes de la complejidad inherente a una orientación data-driven transversal y a los nuevos paradigmas de procesamiento de datos: grandes volúmenes, velocidades elevadas, alta variabilidad, etc.

En este sentido, Red Eléctrica de España (REE) ofreció algunas claves de negocio basadas en su propia experiencia de digitalización:

- La implementación de un cambio tecnológico disruptivo en una gran compañía es complicada. Es preferible comenzar por pequeños prototipos que, aunque analicen pocos datos y produzcan unos resultados limitados, pueden generar un gran valor añadido.

- La disrupción se genera en la cultura de negocio, en los procesos y en los resultados incorporando capacidades analíticas avanzadas y abriendo la puerta a la tecnología. A partir de ahí, se pueden ir integrando en los modelos múltiples capas de datos más complejos. Asimismo, es fundamental incorporar conocimiento interno específico del vertical junto con capacidades de aprendizaje continuo, como captura de feedback o aprendizaje por refuerzo. De esta forma se consigue mejorar la precisión de los modelos, validar los resultados con datos reales, y descubrir nuevas tendencias y variables con una mayor granularidad.

- La capacidad de explotar los canales de negocio desde un cambio disruptivo proporciona incrementos en rendimiento, márgenes, cultura, procesos y nuevos negocios.

Charla relacionada: Disrupting Energy Investment

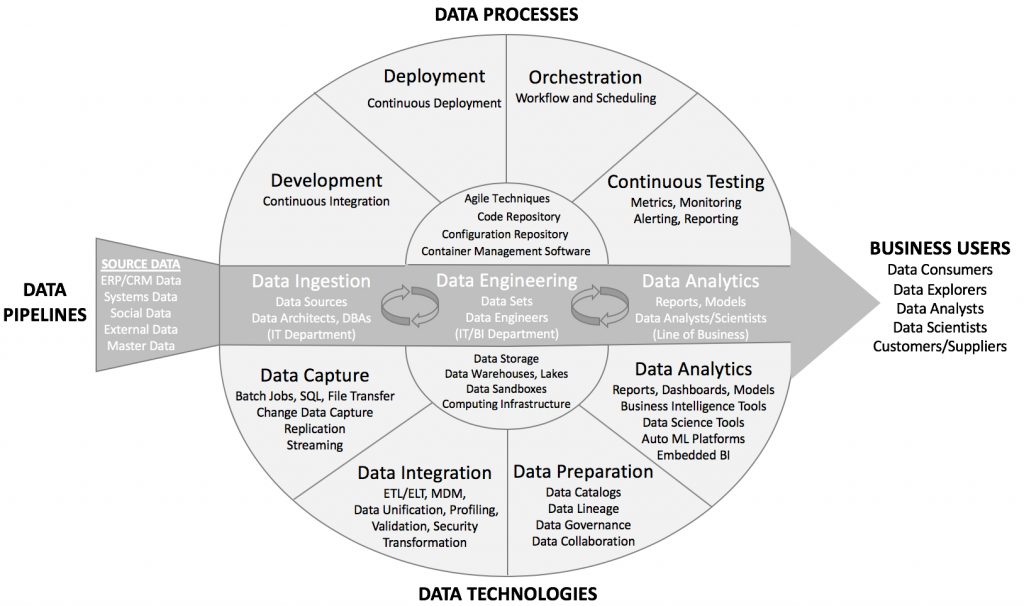

Desde CAPSiDE | NTT explicaron que, del mismo modo que en lean manufacturing la calidad no es una propiedad que surge al final del proceso, o que en DevOps la operación del software no es un último paso en la cadena, en DataOps los llamados data insights tampoco aparecen por arte de magia al final de un pipeline sino que deben estar presentes a lo largo de todo el proceso.

Charla relacionada: Augmented Intelligence taking over AI or humans alone

Figura 1. Componentes de una solución DataOps integral (Fuente: Eckerson Group)

Por su parte, Google mostró que, incluso los ya cotidianos notebooks, como Jupyter, pueden llevarse un paso más allá para lograr que sean totalmente reproducibles y usables en entornos de producción. Y todo ello se consigue integrando en su gestión el análogo a las ‘best practices‘ del desarrollo de software, favoreciendo la automatización con la implementación de pipelines CI/CD (integración continua y entrega continua).

Charla relacionada: Jupyter Notebooks on GCP (Development Best Practices/Tooling)

En buena parte de las charlas se presentaron herramientas y estrategias centradas en facilitar la vida tanto a los científicos de datos como a los ingenieros de datos. Por ejemplo, en otra interesante intervención, Google presentó las ventajas de Kubeflow Fairing, que permite construir, entrenar y desplegar modelos de Machine Learning como endpoints de predicción.

Charla relacionada: Fairing: Bringing Kubernetes for Data Scientists

William Benton, de Red Hat, centró su charla en explicar qué sucede entre la fase de validación y la de despliegue de un modelo de ML que se pretende llevar a producción. Las dificultades habituales tienen que ver con problemas en los pipelines, fallos en las características modeladas, complicaciones a la hora de reproducir resultados, o la aparición de fenómenos de deriva (? drift detection).

Charla relacionada: From trained models to machine learning systems

Logical Clocks presentó su solución Hopsworks para TFX (TensorFlow Extended), una plataforma colaborativa integral para el diseño y operación de aplicaciones de ML y data analytics basada en Apache Beam y Apache Airflow. La plataforma soporta tanto runners de Flink como pipelines de TFX, y permite controlar el proceso completo de construcción: validación de datos, transformación, entrenamiento de modelos de TensorFlow, análisis y servicio de modelos, y monitorización con Kubernetes.

Charla relacionada: End-to-End ML pipelines with Beam, Flink, TensorFlow, and Hopsworks

Por último, Jörg Schad, de ArangoDB, hizo una revisión de MLMD como parte del ecosistema de TensorFlow. MLMD (ML Metadata) es una biblioteca para registrar y recuperar metadatos asociados con workflows habituales de desarrolladores y científicos de datos en Machine Learning. Por ejemplo, los diversos componentes de Kubeflow (entrenamiento distribuido, Jupyter notebooks, optimización de hiperparámetros, almacenamiento de características, etc) continuamente generan metadatos: diferentes conjuntos de datos, diferentes versiones de los notebooks, diferentes parámetros de entrenamiento, diferentes precisiones de entrenamiento/test, diferentes características utilizadas, etc., cuya correcta gestión es crítica a la hora de llevar un sistema a producción.

Charla relacionada: The case for a common Metadata Layer for Machine Learning

Explainable AI (XAI)

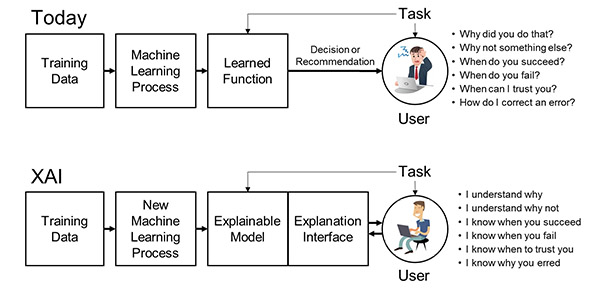

La comunidad se está dando cuenta de la importancia de la Inteligencia Artificial “interpretable”, es decir, de entender por qué un sistema basado en técnicas de ML toma determinadas decisiones. Por ejemplo, por qué el banco ha denegado una solicitud de préstamo, o por qué a un paciente se le ha diagnosticado un cáncer con una confianza del 85%. Grandes actores, como Google (Introducing the What-If Tool for Cloud AI Platform models, o Introducing tf-explain, Interpretability for TensorFlow 2.0) o IBM (AI Explainability 360), están dando pasos importantes en esta dirección.

Figura 2. Concepto de XAI (Fuente: DARPA).

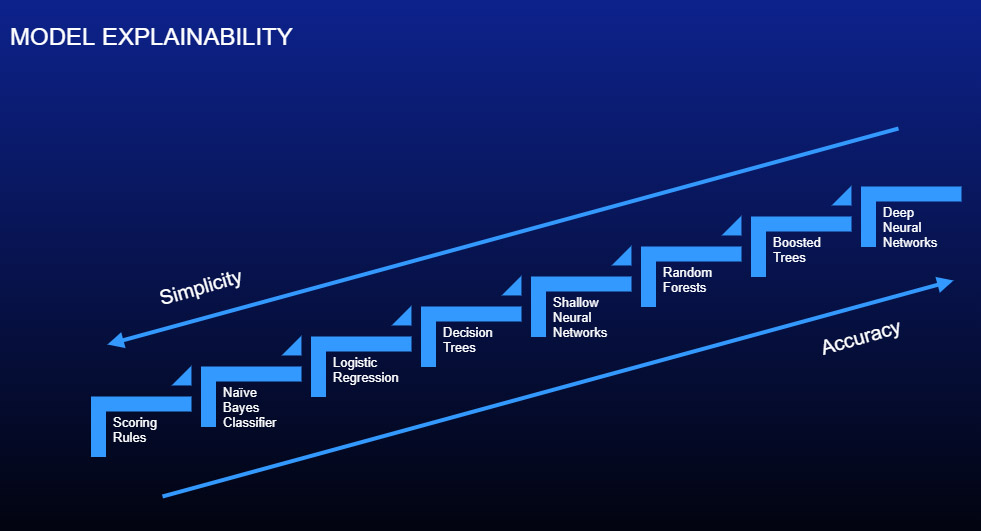

Heather Gorr, de MathWorks, explicó algunas técnicas para conseguir trabajar con modelos de ML más transparentes. Entre ellas está el tratar de visualizar los datos durante todo el proceso; por ejemplo, visualizar, siempre que sea posible, la importancia de las características de nuestros modelos. O usar modelos más simples e interpretables (el ejemplo clásico son los árboles de decisión), si bien es conocido el compromiso existente entre simplicidad (mayor interpretabilidad) y precisión (menor interpretabilidad). Destacó también la importancia de realizar tests rigurosos mediante técnicas de validación de IA, junto con tests en el entorno operacional. En este sentido, pueden ser de gran ayuda las estrategias TDD (Test-Driven Development).

Charla relacionada: Would you trust your model with your life? Research vs. reality in AI

Figura 3. Interpretabilidad de modelos: simplicidad vs. precisión

Augmented Intelligence

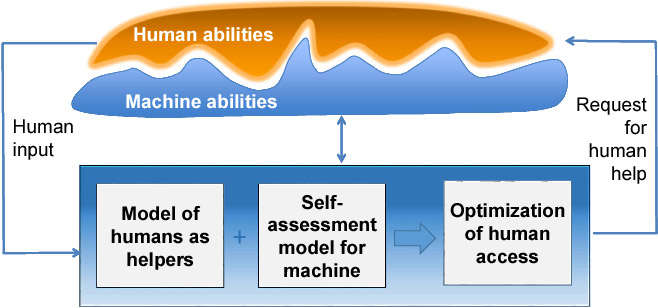

La Inteligencia Aumentada o Híbrida (Hybrid / Augmented Intelligence), sugiere que la inteligencia humana y la inteligencia de las máquinas son complementarias.

La inteligencia humana está modulada por las emociones y la creatividad, pero puede resolver problemas de alta dimensionalidad, con datos escasos y construyendo modelos abstractos. A su vez, la inteligencia de las máquinas puede ser más limitada en cuanto al nivel de percepción, capacidades de aprendizaje, dimensionalidad o creatividad, pero ofrece una capacidad de cálculo masiva.

La sinergia que surge de la combinación de ambas inteligencias ha sido referida en ocasiones como human-in-the-loop. El punto donde los dos tipos de inteligencia compiten a un nivel similar se encuentra actualmente en aplicaciones como el procesamiento de lenguaje natural, la visión, la medicina o la conducción de vehículos. El reto de la Inteligencia Aumentada está en encontrar formas de manejar el conocimiento experto dentro de las organizaciones, y para ello se requiere abundancia de datos, evitar la formación de silos, adoptar un enfoque DataOps y llevar la ciencia de datos a la nube.

Charla relacionada: Augmented Intelligence taking over AI or humans alone

Figura 4. Capacidad de razonamiento de una inteligencia híbrida (Fuente: Microsoft)

AutoML

El concepto de AutoML (Automated Machine Learning) se basa en la automatización del proceso de aplicación de técnicas de ML a problemas del mundo real. Partiendo del requisito de una alta disponibilidad de recursos de computación, este enfoque se ha propuesto como una solución al desafío cada vez mayor de desplegar sistemas de ML en los más diversos ámbitos, a gran escala y a gran velocidad. Por otro lado, el alto grado de automatización que proporciona, permite hacer uso de modelos y técnicas de ML sin necesidad de convertirse primero en un experto en este campo.

Paco Nathan explicó en su charla cómo la mayoría de proveedores cloud están ofreciendo ya algún tipo de servicio de AutoML. En particular, las grandes tecnológicas (Google, IBM, Microsoft, Amazon, etc) están desarrollando servicios de AutoML para sus propias plataformas y haciéndolos open source.

| https://cloud.google.com/automl/ | Cloud AutoML | |

| IBM | https://www.ibm.com/cloud/watson-studio/autoai | AutoAI |

| Microsoft | https://azure.microsoft.com/en-us/services/machine-learning-service/ | Azure Machine Learning service |

| Amazon | https://aws.amazon.com/sagemaker/ | SageMaker |

Es importante dejar claro que cuando hablamos de AutoML nos estamos refiriendo a la automatización potencial en todas las etapas del workflow habitual en sistemas de machine learning: preparación de datos (meta-learning), ingeniería de características (feature selection), entrenamiento de modelos (hyperparameter optimization), evaluación de resultados (model selection), integración y despliegue (auto scaling). Esto hace que nos encontremos típicamente ante un problema multi-objetivo: precisión (precision, recall, specificity, perplexity), fiabilidad/incertidumbre, coste computacional, coste temporal, escalabilidad, huella de carbono, deriva, sesgo, privacidad, compliance, interpretabilidad, etc. Nathan aseguró que estas aproximaciones no funcionarán bien mientras no esté disponible públicamente un buen conjunto de comparativas de referencia.

Charla relacionada: Unpacking AutoML

Incremental learning

Desde MathWorks mostraron cómo aplicar técnicas de ML al mantenimiento predictivo, de forma que se maximice la eficiencia en cadenas de suministro o de fabricación. Para poder tomar decisiones en cuasi tiempo-real, a menudo se diseñan sistemas de procesado basados en la arquitectura Lambda, un híbrido entre procesado en tiempo real y procesado batch. Aun así, subsiste el problema de trabajar con modelos estáticos en la parte relativa a tiempo real, ya que una nueva tendencia podría no detectarse hasta que el modelo se actualiza. Existe una nueva clase de técnicas de machine learning que permiten aumentar la responsividad y la precisión mediante la actualización dinámica de los modelos en cuasi tiempo-real: es el llamado aprendizaje incremental (Incremental / Online Learning). Algunos de los algoritmos tradicionales pueden ser adaptados en este sentido, de forma que pueden procesar grandes streams de datos de forma continua.

Charla relacionada: Fix it before it Breaks: Incremental Learning for Predictive Maintenance

Por su parte, Intel presentó la implementación de una arquitectura escalable y asíncrona de procesamiento en streaming capaz de gestionar terabytes de datos para construir un grafo de conocimiento (knowledge graph) creciente que se mantiene permanentemente actualizado y que utilizan para detectar enlaces entre clientes potenciales y, como resultado, mejorar la atención hacia sus clientes actuales. Actualmente, el grafo contiene decenas de millones de entidades conectadas, y cada hora nuevos miles se obtienen, enriquecen y conectan al grafo en tiempo real. Su arquitectura se basa en las tecnologías Kafka Streams, RAY, TensorFlow Serving y Neo4J.

Charla relacionada: Sales AI: Building and maintaining a knowledge graph

Autor: Rafael P. Martínez, ingeniero-investigador del área de Sistemas Inteligentes de Gradiant.