Día a día nos encontramos situaciones en las que es esencial comprender correctamente los mecanismos subyacentes a partir del análisis de datos generados por todo tipo de sistemas. Tenemos ejemplos muy claros en el ámbito de la ciberseguridad, donde resulta fundamental apuntar al origen de una amenaza, dados unos indicios de ataque; o en el ámbito de la Industria 4.0, donde es igualmente decisivo saber qué hacer y dónde actuar cuando se detecta un fallo en un sistema o proceso productivo.

Suele decirse que correlación no implica causalidad, aunque, de forma inadvertida, en ocasiones caemos en el error de suponer que existe una relación causal entre dos variables que siguen un cierto patrón común. En este post vamos a revisar algunas implicaciones que se deben tener en cuenta a la hora de trabajar con técnicas de análisis causal. Este tipo de técnicas son de gran utilidad para determinar con certeza el origen de un problema cuando sólo observamos algunos síntomas.

Calentando motores: Regresión y causalidad

De acuerdo, correlación no implica causalidad. ¿Y una regresión lineal implica causalidad?

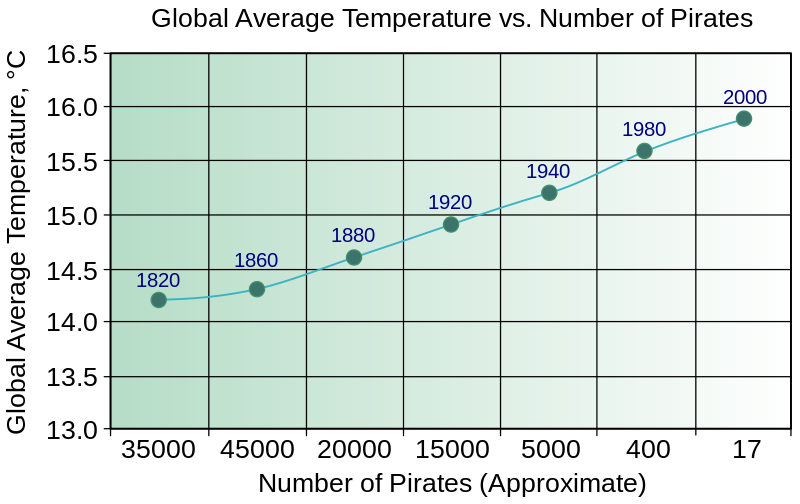

La respuesta rápida es que no. Es fácil encontrar ejemplos de datos no relacionados que, tras un cálculo de regresión, logran pasar todo tipo de test estadísticos. El siguiente es un ejemplo popular que ilustra el concepto de “causalidad” data-driven.

A la vista de los datos, ¿necesitamos más piratas para enfriar el planeta? ¿O tal vez los piratas son extremadamente sensibles al incremento de la temperatura media global?

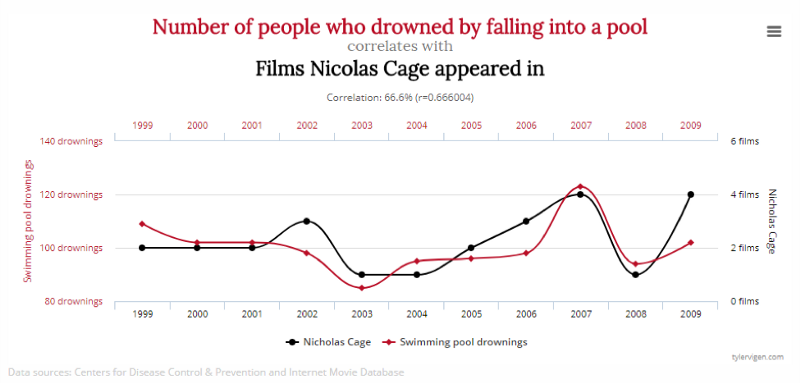

A veces se dice que este tipo de “causalidad” está sólo en el ojo del que mira. En clave de humor es célebre la página Spurious Correlations de Tyler Vigen.

Para series temporales existe el concepto de causalidad en el sentido de Granger. El llamado test de Granger tiene por objeto deducir si el comportamiento actual y pasado de una serie temporal A predice el comportamiento de una serie temporal B. Su principal limitación es que encuentra sólo la “causalidad predecible”, y que, mal utilizado, puede conducir a conclusiones absurdas como las comentadas anteriormente. Bien es cierto que su simplicidad computacional hace que se siga empleando como herramienta básica de análisis causal.

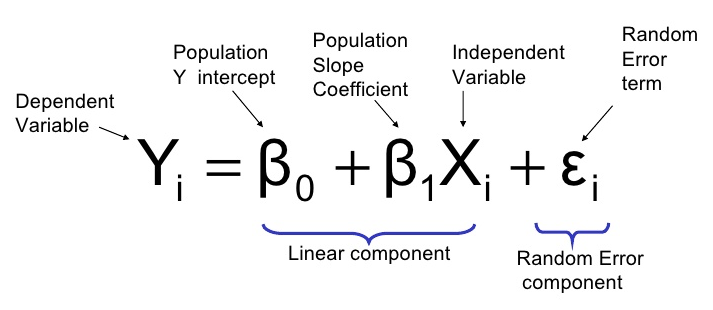

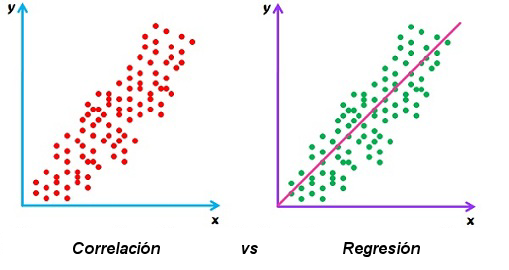

Antes de continuar, veamos la diferencia entre correlación y regresión, que son dos tipos de análisis que a veces tienden a mezclarse y confundirse. El análisis basado en correlación permite cuantificar el grado en que se relacionan dos variables. En cambio, el análisis basado en regresión trata de encontrar la mejor recta (o curva) de ajuste para predecir el valor de una variable dependiente Y a partir del valor conocido de una variable independiente X. En la correlación ambas variables están en igualdad de condiciones (el coeficiente de correlación es el mismo si se intercambian). Por contra, en una regresión sí importa cuál es X y cuál es Y, ya que la función que mejor predice Y a partir de X en general no coincide con la función que mejor predice X a partir de Y.

¿La ausencia de correlación implica ausencia de causalidad?

La respuesta es que esto tampoco es cierto. Como contraejemplo sirve cualquier sistema de control. El control es claramente imposible sin relaciones causales, pero conseguir controlar algo significa, a grandes rasgos, que alguna variable se mantiene constante, lo cual implica que dicha variable no estará correlacionada con otras variables, incluyendo aquellas que provoquen que sea constante.

Un ejemplo es el termostato de Milton Friedman. Como se sabe, cuando se presiona el acelerador de un vehículo, este va más rápido. Y si el vehículo tiene que subir una pendiente, entonces va más despacio. Pero supongamos que esta información es desconocida para un pasajero que ve cómo el conductor trata de mantener una velocidad constante en una carretera de montaña. El pasajero verá el pedal del acelerador subir y bajar, y al coche descender y ascender. Si el conductor es habilidoso y el coche suficientemente potente, notará que el vehículo mantiene una velocidad constante. Así que, si sólo observa estas variables, podría concluir fácilmente que la posición del pedal no tiene ningún efecto en la velocidad, o que la pendiente del trazado tampoco tiene efecto alguno.

No hay forma de evitar esta mala interpretación por medio de técnicas de regresión multivariable entre velocidad, posición del pedal y pendiente. Ello se debe a que, en este caso, la posición del pedal y la pendiente son perfectamente colineales. Además, entre la posición del pedal y la velocidad, lo mismo que entre la pendiente y la velocidad, la correlación observada es nula.

¿Causalidad implica correlación?

Sabemos que puede haber múltiples explicaciones para la correlación. Pero démosle la vuelta a la implicación: ¿Causalidad implica correlación? Pareciera que sí. Pero nuevamente, la respuesta es que no tiene por qué.

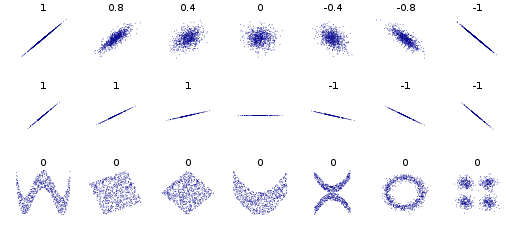

En primer lugar, que haya causalidad no implica que exista algún tipo de correlación lineal (que es la manera en que suele imaginarse la correlación entre dos variables). Concretamente, el coeficiente de correlación (r) refleja cómo cambia una variable cuando lo hace la otra: si r es positivo, existe una tendencia a que una variable suba cuando la otra sube; si r es negativo, existe una tendencia a que una variable suba cuando la otra baja. Sin embargo, el coeficiente de correlación no ofrece información sobre la intensidad de dicha relación ni sobre muchos otros aspectos en relaciones no lineales, tal y como muestra la siguiente figura con varios conjuntos de puntos (x, y).

En segundo lugar, que exista causalidad entre dos variables ni siquiera implica que pueda medirse algún tipo de correlación entre ellas.

Para ilustrarlo con un ejemplo, supongamos que tiramos sucesivamente dos monedas y que sólo cuando ambas muestran el mismo resultado -dos caras o dos cruces- un sistema enciende una bombilla. Podemos afirmar que tanto una moneda como la otra provocan que la bombilla se encienda o se apague (es evidente que existe causalidad). Sin embargo, si observamos una de las monedas y el estado de la bombilla, no podremos establecer ningún tipo de correlación o de dependencia estadística.

En teoría de la probabilidad y en teoría de la información, el concepto de información mutua mide la dependencia existente entre dos variables aleatorias. Es decir, mide la reducción de la incertidumbre de una variable aleatoria debido al conocimiento del valor de la otra (está, por tanto, estrechamente ligado al concepto de entropía). Para relaciones no lineales como las de la fila inferior en la figura previa, Y podría estar perfectamente causado por X, pero la correlación entre ambas variables es nula. Lo que sí podemos afirmar en esos casos es que causalidad implica una alta información mutua.

Transitividad y bidireccionalidad causal

Si tenemos una cadena causal probabilística del tipo A → B → C, es decir, donde A causa B, y donde B causa C, ¿podemos deducir que A causa C?

De nuevo, la intuición puede jugarnos una mala pasada y la respuesta (a estas alturas, esperable) es que no necesariamente. La explicación formal es que sólo se puede garantizar que las relaciones causales probabilísticas son transitivas si se cumple la llamada condición de Markov. Esta condición se relaciona con el concepto de independencia condicional y explica que, conocido el presente, el futuro no depende del pasado.

En general, la intransitividad causal puede deberse a diversas razones [1]. Una de las más comunes es la fragmentación causal. Veamos dos ejemplos: La cadena “hacer ejercicio” → “tener sed” → “beber agua” puede entenderse como un mecanismo o fragmento unitario, por lo que es posible asumir una relación de transitividad causal (esto es, “hacer ejercicio” provoca “beber agua”). Sin embargo, consideremos esta canción popular inglesa con reminiscencias de efecto mariposa:

Por un clavo se perdió una herradura,

por una herradura, se perdió un caballo,

por un caballo, se perdió una batalla,

por una batalla, se perdió el Reino.

Y todo por un clavo de una herradura

Si bien cada vínculo causal en la cadena puede parecer plausible, la conexión causal global entre la primera causa y el último efecto se antoja demasiado débil, lo cual, desde un punto de vista analítico, conduce a intransitividad causal.

Otro aspecto interesante de las relaciones causales es que puede existir causalidad bidireccional o recíproca, dando lugar a mecanismos de realimentación. Por ejemplo, en sistemas biológicos dinámicos con depredadores y presas, el número de depredadores afecta a la evolución en el número de presas y, al mismo tiempo, el número de presas afecta a la evolución en el número de depredadores.

¿Bajo qué condiciones correlación implica causalidad?

Veamos el siguiente ejemplo: se puede realizar un experimento sobre gemelos idénticos de los que se sabe que obtienen constantemente las mismas calificaciones en sus exámenes. A un gemelo se le pone a estudiar durante seis horas mientras que el otro se va a jugar al parque. Si de repente los resultados divergen claramente, esto podría tomarse como una fuerte evidencia de que estudiar (o jugar en el parque) produce un efecto causal en las notas obtenidas. En este caso, la correlación entre estudiar y los resultados de los exámenes casi con toda seguridad implica causalidad.

Pero correlación no es una condición suficiente de causalidad. En el ejemplo anterior se podría argumentar que los gemelos siempre hacen trampas en los exámenes mediante un dispositivo que les chiva las respuestas, y que el gemelo que va a jugar al parque pierde su dispositivo; de ahí su baja calificación.

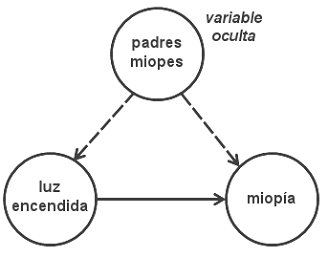

Una buena manera de clarificar todo esto es imaginar la estructura de la red bayesiana que puede estar generando los datos observables, tal y como propone Pearl en su libro Causality [2]: la clave consiste en localizar posibles variables ocultas. Esto es, si existe alguna variable oculta de la cual dependen los datos observados, entonces correlación no implicaría causalidad (hablaríamos de una relación espuria). Sólo cuando descartamos todas las variables ocultas se puede inferir una relación causal.

Veámoslo con otro ejemplo: Los niños que duermen con la luz encendida son más propensos a desarrollar miopía temprana. Por tanto, dormir con la luz encendida causa miopía. Sin embargo, investigaciones posteriores encontraron un fuerte vínculo entre la miopía de los padres y el desarrollo de miopía infantil. Además, se descubrió que los padres miopes tenían una mayor tendencia a dejar una luz encendida en el cuarto de sus hijos. Como muestra el siguiente grafo causal, esa era la variable oculta.

Consideraciones prácticas

Respondiendo a la pregunta que nos hacíamos al principio: ¿qué implica entonces que exista correlación entre A y B? En este post no hemos profundizado en técnicas o algoritmos de análisis causal ni en las matemáticas que permiten modelar o medir la incertidumbre. En cualquier caso, la recomendación es plantear una lista con todas las opciones posibles y tratar de revisar metódicamente cada una de ellas para determinar cuál es la más probable. Así pues, si A está correlacionado con B, entonces:

- A podría causar B

- B podría causar A

- C podría causar tanto A como B

- Los datos podrían ser deficientes

- Podría tratarse de una casualidad

El principio de causa común de Reichenbach (Common Cause Principle, o CCP) [3] establece que si ocurre una coincidencia improbable, debe existir una causa común. Esto equivale a decir que las correlaciones fuertes tienen explicaciones causales. Por ejemplo, supongamos que en una habitación dos bombillas se apagan de repente. Se considera improbable que, por casualidad, ambas bombillas se fundan a la vez, así que buscaremos la causa en un fusible común quemado o en alguna otra interrupción general del suministro eléctrico. La coincidencia improbable se explica, de este modo, como resultado de una causa común.

Análisis causal y Big Data

En Gradiant trabajamos en diversos proyectos de analítica Big Data donde resulta esencial identificar correctamente situaciones en las que existe causalidad. Un término de moda en el ámbito IT es el de análisis de causa raíz (Root Cause Analysis, o RCA). En este contexto, el uso de técnicas de modelado e inferencia causal es clave para investigar y resolver eficazmente problemas que resultan ser la causa de incidencias que están afectando a uno o varios servicios. El desafío es doble cuando se combinan Big Data y tiempo real, pues los algoritmos no sólo han de ofrecer una alta certidumbre en sus resultados, sino que además han de responder con la mayor velocidad posible: una notificación rápida y precisa puede suponer el ahorro de mucho tiempo y dinero.

Realmente estas técnicas no buscan reemplazar a los analistas humanos sino ser una potente herramienta de trabajo para ellos. Poder entrenar una inteligencia artificial con la precisión de un experto, pero capaz de analizar ingentes cantidades de datos, constituye un reto apasionante que abordaremos en un futuro post.

Referencias

[1] Samuel G. B. Johnson and Woo-Kyoung Ahn, “Causal Networks or Causal Islands? The Representation of Mechanisms and the Transitivity of Causal Judgment”. Cognitive Science, 2015.

[2] Judea Pearl, “Causality: models, reasoning and inference”. Cambridge University Press, 2009.

[3] Hans Reichenbach, “The Direction of Time”. Dover Publications Inc., 2003.

Autor: Rafael P. Martínez, investigador senior en el área de Sistemas Inteligentes en Red (INetS) de Gradiant