En la actualidad, el uso de las nuevas tecnologías en el día a día es una realidad a la que todos estamos más que acostumbrados. Cada día, todos nosotros interactuamos con la tecnología en el trabajo, en el tiempo de ocio y, cada vez más, en la educación. Se trata de una tendencia que parece no tener límites y que se está viendo fortalecida por la aparición de sistemas basados en inteligencia artificial y que transformarán muchos de los productos y servicios que usamos diario.

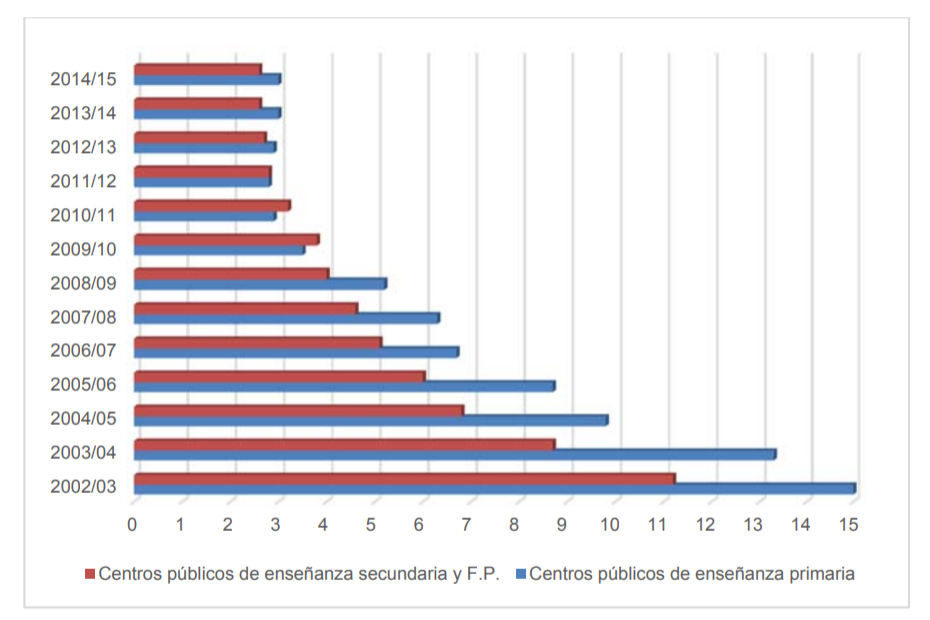

Concretamente en el ámbito educativo, los últimos datos disponibles del Ministerio de Educación y Ciencia español -correspondientes al curso académico 2014/2015-, revelan que el número medio de alumnos por ordenador destinado a tareas de enseñanza y aprendizaje, en los centros públicos de enseñanza primaria, secundaria y formación profesional se sitúa en menos de 3 para todos los casos. La gráfica que se muestra a continuación, elaborada por el Instituto Nacional de Tecnologías Educativas y de Formación del Profesorado (INTEF), representa esta evolución. Además, el 92.7% de las aulas dedicadas a clase tiene acceso a Internet, siendo de banda ancha en el 68,4% de los casos.

Estas tendencias se hacen también evidentes en el crecimiento de las investigaciones en Technology Enhanced Learning (TEL) y en la evolución de los sistemas educativos y del propio mercado EdTech. Teniendo en cuenta dicha pujanza, en este artículo queremos profundizar en la descripción de uno de los sistemas con más presencia en las investigaciones y en el mercado de los últimos años: los tutores inteligentes o ITS, Intelligent Tutoring System por sus siglas en inglés. A continuación se describen en detalle, indicando sus funcionalidades, fundamentos matemáticos así como el trabajo de Gradiant en esta área.

Tutores inteligentes, ¿qué son y cómo funcionan?

Un ITS es una herramienta de enseñanza basada en las TIC que determina la secuencia y presentación de contenidos basados en el rendimiento de los estudiantes (Nedungadi, 2015). Para ello tiene en cuenta características del alumno, resultado de una evaluación psicométrica que el sistema realiza de manera automática; así como las características de los contenidos y/o actividades. Éstas estarán etiquetadas indicando cuáles son las competencias necesarias para su correcto entendimiento y resolución (por ejemplo, para una determinada actividad de matemáticas, las competencias podrían ser: suma de fracciones y multiplicación). Los algoritmos empleados por los tutores inteligentes emplean la información obtenida para recomendar cuál es la siguiente actividad o contenido a mostrar. Estos sistemas constituyen la base del paradigma “educación personalizada”, donde los contenidos y la velocidad de presentación de los mismos se adaptan a cada alumno. Se han hecho pruebas piloto donde se ha demostrado que la educación personalizada reduce la tasa de abandono escolar.

Una variante, o subconjunto, de los tutores inteligentes son los tests adaptativos por ordenador (CAT – computerized adaptive testing). Se mantiene la idea de presentar contenidos de manera dinámica, pero en este caso se restringe a los ítems de un test. Se trata de una evolución respecto a la manera tradicional, donde el profesor diseña las pruebas de manera estática, con un orden predefinido de los ítems a administrar y sin posibilidad de adaptarlo a cada alumno en función de su rendimiento.

En cualquier caso, se trata de un proceso iterativo, donde el sistema recibe información continua de cómo el alumno interactúa con la plataforma. A partir de dicha información se generan modelos matemáticos que describen la manera en que el alumno adquiere conocimientos conforme avanza el uso del sistema. Finalmente, se emplean dichos modelos para elegir la siguiente actividad o contenido a presentar al alumno, de manera que la dificultad y competencias necesarias sean coherentes con sus habilidades en ese momento.

En este proceso se identifican varios aspectos a tener en cuenta con distintos retos a resolver:

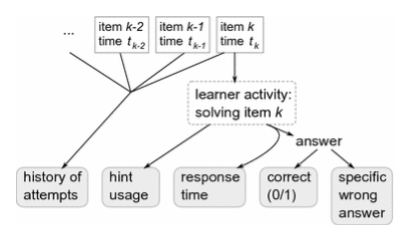

- Datos observables. Cuanta más información se obtenga de la interacción del alumno con la plataforma, más precisos podrán ser los modelos a aplicar. En lo que se refiere a la resolución de actividades se consideran datos como el histórico de intentos, el uso de ayudas, los tiempos de respuesta y la respuesta obtenida. Un valor concreto de una respuesta errónea proporciona también mucha información a los modelos (Pelanek, 2017).

- Modelado del test. Estemos ante un ITS completo o un CAT, las respuestas a los ítems son de vital importancia ya que dan información acerca del nivel de conocimiento adquirido por el alumno. El tipo de ítems que componen un test, así como el funcionamiento del test, pueden ser muy diversos. Se enumeran a continuación algunas de las variables que los definen y que condicionarán el modelo:

- duración del test. El test puede tener una duración temporal determinada, un número de ítems fijo o tener longitud variable en función del nivel de conocimiento adquirido por el alumno, es decir, el test terminará cuando el alumno haya alcanzado un determinado nivel de conocimiento;

- respuestas dicotómicas o politómicas. Las respuestas se pueden evaluar en modo binario, es decir, obtener la máxima puntuación o la mínima, o bien existir puntuaciones intermedias. El primer caso se trata de los modelos dicotómicos, mientras que el segundo se denominan politómicos. Estos últimos abarcan actividades de distinta naturaleza, como tests con respuesta múltiple o resolución de un problema en varios subproblemas;

- la correcta resolución de cada actividad puede requerir una o más competencias por parte del alumno, requiriendo entonces modelos uni o multidimensionales, respectivamente.

- dichas competencias pueden estar relacionados entre sí, de manera que la adquisición de algunas ayude a la obtención de otras

- la materia sobre la que versa el test puede encajar mejor en unos modelos que en otros. Por ejemplo, un test de idiomas podría encajar mejor en modelos distintos a los tests de matemáticas.

Modelos matemáticos

Una parte central de los modelos es la evaluación psicométrica del alumno. No existe una medida explícita del nivel de conocimientos, por lo que se debe inferir a partir de mediciones indirectas. En la literatura este nivel de conocimiento se denomina como rasgos latentes y ha sido estudiado desde distintas áreas de conocimiento. Así, la comunidad científica dedicada a la mejora de los sistemas de evaluación ha usado tradicionalmente la teoría de la respuesta al ítem, o IRT, por sus siglas en inglés (Item Response Theory); el área dedicada al modelado del conocimiento ha desarrollado modelos bayesianos (BKT – bayesian knowledge tracing); por su lado la psicología ha desarrollado modelos cognitivos (CDM – cognitive diagnosis models).

Los modelos usados actúan en dos niveles distintos, atendiendo a su granularidad. Por un lado están los modelos para trabajar en el inner loop, o cómo el alumno interactúa con cada actividad; y por otro está el outer loop, que pone el foco en la secuencia de actividades, esto es, en decidir cuál es la siguiente actividad a partir de la información obtenida hasta el momento (Pelanek, 2017). En el inner loop (usado especialmente en problemas que se pueden dividir en múltiples pasos), el sistema es capaz de interactuar con el alumno proporcionando ayuda o explicaciones en tiempo real. En el outer loop entran en juego modelos como Item Response Theory o Bayesian Knowledge Tracing. De lo anterior se deduce que el inner loop actúa en el corto plazo, mientras que el outer loop está especialmente dedicado al medio plazo. Se podría incluir una tercera categoría que afecta a predicciones a largo plazo, como suspenso en un curso (Barber, 2012) o incluso abandono escolar (Kovačić, 2010).

Las familias de modelos citados han sido diseñados expresamente para el modelado cognitivo del alumno, incluyendo parámetros semánticos, esto es, que caracterizan un rasgo observable, lo que facilita su interpretación (Wilson, 2016). En el lado opuesto, se encuentran las más recientes técnicas de machine learning, como RNN o LSTM, conocidas popularmente como deep learning. Estas técnicas se basan en modelos genéricos donde no hay una correspondencia entre sus parámetros y los rasgos observables externamente. De esta manera se consiguen modelos más complejos, cuyos resultados están empezando a superar a los usados anteriormente. Si bien, hasta la fecha no han obtenido el éxito esperado debido a la dificultad de interpretabilidad (Pelanek, 2017), que impide que sus resultados se traduzcan a acciones concretas por parte de los profesores.

El rol del profesor

La progresiva tecnificación que está experimentando el mundo de la educación no implica la sustitución del rol de profesor. De hecho, se potencia su labor al proporcionarle información útil para mejorar su papel para con los alumnos. Además, se automatizan tareas rutinarias, dejando más tiempo útil para dedicarle al alumno. Algunos autores de relevancia profundizan en esta idea. Así Baker (Baker, 2016) resalta que “el objetivo no es crear tutores más o menos inteligentes, sino crear estudiantes inteligentes y exitosas”. Para ello defiende el “diseño inteligente de tutores”. Essa (Essa, 2016) destaca el papel del profesor en el inner loop, permitiendo una mayor automatización en el outer loop. Por otro lado, existen cuestiones tecnológicas que aconsejan limitar la automatización. Así, las experiencias hasta la fecha de sistemas con un nivel de detalle elevado reportan que requieren mucho tiempo para su puesta a punto y generación de contenidos. Esta dificultad se agrava al tener en cuenta que el perfil de los alumnos evoluciona a lo largo del tiempo debido, por ejemplo, a cuestiones coyunturales y al contexto social del momento, lo que implicaría actualizaciones demasiado frecuentes de los modelos (Baker, 2016).

edTech en Gradiant

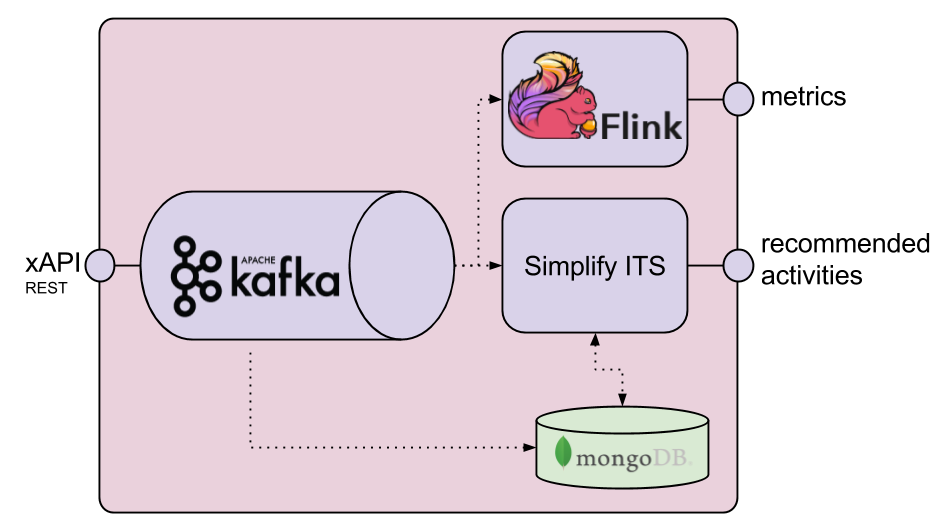

En una entrada anterior se explicaban las diferencias entre EDM (Educational Data Mining) y Learning Analytics, y cómo esta última es la tendencia actual en el ámbito EdTech y una línea de investigación activa en Gradiant, por ejemplo a través del proyecto Simplify, centrado en ofrecer herramientas de soporte al educador que ayuden a entender mejor el proceso de aprendizaje y los problemas de sus alumnos, dedicando menos esfuerzo a las tareas más rutinarias de supervisión y ofreciendo un mecanismo de refuerzo del aprendizaje. Entre estas herramientas destacan:

- un motor psicométrico, que genera reportes detallados de la evolución del alumno en las distintas dimensiones: motivación, esfuerzo, comportamiento social, autonomía y rendimiento.

- un módulo tutor, que implementa el comportamiento explicado en este artículo: recomienda las actividades que debe realizar un alumno a partir de los datos obtenidos de la interacción con la plataforma. Como modelo se ha empleado DINA (deterministic, input, noisy and gate), que pertenece a la familia de modelos cognitivos, o CDM. En este modelo se considera que el profesor etiqueta las competencias asociadas a cada actividad y que el alumno debe poseer todas las competencias asociadas a dicha actividad para poder realizarla correctamente.

La figura anterior muestra, de manera muy resumida, las piezas que forman parte de Simplify. Una imagen más detallada incluiría otros elementos, frecuentes en arquitecturas de datos, como Grafana, Telegraf, InfluxDB o ElasticSearch, pero están fuera del objetivo de este artículo.

Referencias

Nedungadi and M. S. Remya, «Incorporating forgetting in the Personalized, Clustered, Bayesian Knowledge Tracing (PC-BKT) model,» 2015 International Conference on Cognitive Computing and Information Processing(CCIP), Noida, 2015, pp. 1-5.

Pelánek, R. Bayesian knowledge tracing, logistic models, and beyond: an overview of learner modeling techniques, “User Modeling and User-Adapted Interaction”, 2017, pp. 313-350

Barber, R., Sharkey, M. (2012) Course correction: using analytics to predict course success. Proceedings of the 2nd International Conference on Learning Analytics and Knowledge, New York, NY: ACM, 259–262.

Kovačić, Z. (2010). Early Prediction of Student Success: Mining Students Enrolment Data. Proceedings of Informing Science & IT Education Conference (InSITE), 647–665.

H. Wilson, X. Xiong, M. Khajah, R. V. Lindsey, S. Zhao, Y. Karklin, E. G. Van Inwegen, B. Han, C. Ekanadham, J. E. Beck, et al. Estimating student proficiency: Deep learning is not the panacea. In In Neural Information Processing Systems, Workshop on Machine Learning for Education, 2016

Baker, R.S.: Stupid tutoring systems, intelligent humans. Int. J. Artif. Intell. Educ. 26(2), 600–614 (2016)

Essa, A.: A possible future for next generation adaptive learning systems. Smart Learn. Environ. 3(1), 16 (2016)

Autor: Andrés Estevez Costas, investigador – desarrollador senior de eLearning en el área de Servicios y Aplicaciones de Gradiant